我的保研之路

2024年9月25日,我收到了北大的拟录取通知,当时感觉一切都释然了,仿佛做梦一般,怎么也想不到会是这个结果。接下来就看看这一路走来的颠沛流离吧,以此送给我过去付出的点点滴滴。

1 大一机械转专业1.1 报志愿刚上大一的时候还是机械专业,我高考分数是597分,从下面可以看到东秦在我们省机械类专业的最低分数线是596,可以说几乎是压线进来的。当时报考东秦的时候完全是从我报了一个报考辅导机构,然后机构中有一个系统,你输入选课、高考分数和位次之后会自动筛选出一些学校,东秦也就是筛选出来的。我自己在报考之前完全不知道有这个学校。

就是这样,我就在96个志愿中的好像是第11个志愿填上了东北大学秦皇岛分校—机械类专业。记得当时出录取结果的时候,我和父亲在超市里买东西,知道结果后,好像挺开心的当时,一方面是有大学上了,其次是个985(虽然是末9)。

1.2 大一上学期的懵懂在上大学之前,我就和母亲了解过东秦可以转专业,但是当时也仅仅是了解,而且知道转专业都是学习好的转,不是随便转的。

开学之后,对我的大学生活和大学规划一无所知,其实也不知道自己以后要干什么,要不要转专业,要不要考研。现在想来这也是 ...

论文精读4:GAN

1 Abstract我们提出了一种通过对抗过程估计生成模型的新框架,在该框架中,我们同时训练两个模型:一个生成模型$G$,它捕捉数据分布;以及一个判别模型$D$,它估计样本来自训练数据而非$G$的概率。$G$的训练过程是最大化$D$犯错误的概率。此框架对应于一个极小极大两人博弈。在任意函数$G$和$D$的空间中,存在一个唯一解,即$G$复现训练数据分布,而$D$在各处等于$\frac{1}{2}$。若模型$G$和$D$由MLP定义,整个系统可通过反向传播进行训练。在训练或样本生成过程中,无需任何马尔可夫链或展开的近似推断网络。实验通过定性和定量评估生成的样本来展示该框架的潜力。

2 Introduction深度学习的潜力在于发现丰富的、层次化的模型[2],这些模型能够表示人工智能应用中遇到的各种数据的概率分布,例如自然图像、包含语音的音频波形以及自然语言语料库中的符号。迄今为止,深度学习中最显著的成功涉及判别模型,通常是将高维、丰富的感官输入映射到类标记[14, 20]。这些显著的成功主要基于反向传播和暂退法算法,使用分段线性单元[17, 8, 9],这些单元具有特别良好的梯度特性。 ...

计算机组成原理第10章:控制单元的设计

1 组合逻辑设计1.1 组合逻辑控制单元框图如果将指令译码和节拍发生器从CU中分离出来,可得到简化的控制单元框图如下:

1.2 组合逻辑设计步骤1.2.1 列出操作时间表

1.2.2 写出微操作命令的最简表达式根据上述操作时间表可以列出每一个微操作命令的初始逻辑表达式,经化简、整理便可获得能用现成电路实现的微操作命令逻辑表达式。例如:

$$\begin{array}{l}\\mathrm{M}(\mathrm{MAR}) \longrightarrow \mathrm{MDR} \\=\mathrm{FE} \cdot T_{1}+\mathrm{IND} \cdot T_{1}(\mathrm{ADD}+\mathrm{STA}+\mathrm{LDA}+\mathrm{JMP}+\mathrm{BAN}) \\+\mathrm{EX} \cdot T_{1}(\mathrm{ADD}+\mathrm{LDA}) \\=T_{1}{\mathrm{FE}+\mathrm{IND}(\mathrm{ADD}+\mathrm{STA}+\mathrm{LDA}+ ...

计算机组成原理第9章:控制单元的功能

1 微操作命令的分析控制单元具有发出各种微操作命令(即控制信号)序列的功能。

1.1 取值周期假设CPU内含有4个寄存器:

MAR与地址总线相连,存放欲访问的存储单元地址

MDR与数据总线相连,存放欲写入存储器的信息或最新从存储器中读出的信息

PC存放现行指令的地址,有计数功能

IR存放现行指令

取值周期的过程归纳如下:

1.2 间址周期

1.3 执行周期不同指令的指令周期的微操作是不同的,下面分别讨论非访存指令、访存指令和转移类指令的微操作。

1.3.1 非访存指令

清除累加器指令CLA:$0 \rightarrow \mathrm{ACC}$

累加器取反指令COM:$\overline{\mathrm{ACC}} \rightarrow \mathrm{ACC}$

算术右移一位指令SHR:$\mathrm{L}(\mathrm{ACC}) \rightarrow \mathrm{R}(\mathrm{ACC}), \mathrm{ACC}{0} \rightarrow \mathrm{ACC}{0}$

循环左移一位指令CSL:$\mathrm{R}(\mathrm{ACC}) ...

计算机组成原理第8章:CPU的结构和功能

1 CPU的结构1.1 CPU的功能CPU实质包括运算器和控制器两大部分。控制器负责协调并控制计算机各部件执行程序的指令序列,其基本功能是取指令、分析指令和执行指令。

简述CPU的功能如下:

CPU具有控制程序的顺序执行,即指令控制

产生完成每条指令所需的控制命令,即操作控制

对各种操作实施时间上的控制,即时间控制

对操作数进行算术运算和逻辑运算,即数据加工

处理中断

1.2 CPU的结构框图指令控制需要:寄存器、控制单元CU;数据加工需要:ALU;中断控制需要:中断系统。此外,还需要系统总线,即控制总线、地址总线和数据总线。

1.3 CPU的寄存器CPU的寄存器大致可分为两类:

一类属于用户可见寄存器,用户可以这类寄存器编程。

另一类属于控制和状态寄存器,用户不可对这类寄存器编程,它们被控制部件使用,以控制CPU的操作。

1.3.1 用户可见寄存器

通用寄存器:可由程序设计者指定许多功能,可用于存放操作数,也可作为满足某种寻址方式所需的寄存器。

数据寄存器:用于存放操作数。

地址寄存器:用于存放地址,其位数应满足最大的地址范围。

条件码寄存器:存放条件码,可作程序分支的依据 ...

编译原理第8章:语义分析和中间代码生成

1 声明语句的翻译主要任务:分析所声明$id$的性质、类型和地址,在符号表中为$id$建立一条记录。

1.1 类型表达式设有C程序片段:

1234567struct stype{ char name[8]; int score;};stype table[50];stype* p;

和stype绑定的类型表达式:record((name × array(8, char)) × (score × integer))

和table绑定的类型表达式:array(50, stype)

和p绑定的类型表达式:pointer(stype)

1.2 局部变量的存储分配对于声明语句,语义分析的主要任务就是收集标识符的类型等属性信息,并为每一个名字分配一个相对地址。

从类型表达式可以知道该类型在运行时刻所需的存储单元数量称为类型的宽度$(width)$

在编译时刻,可以使用类型的宽度为每一个名字分配一个相对地址

名字的类型和相对地址信息保存在相应的符号表记录中。

2 赋值语句翻译赋值语句的基本文法:

$S \rightarrow \mathrm{id} ...

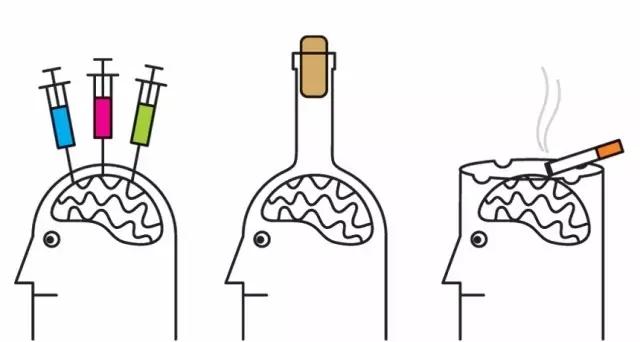

心理学:成瘾机制

1 柯立芝效应研究发现,大多数哺乳动物在交媾之后的一段时间内,即使原有的配偶就在身边,也不再有性行为,这个阶段称为性不应期。但是,如果在雄性动物交媾之后,重新给它一个新的雌性发情对象,它的不应期会大大缩短,甚至立即又出现交媾行为。

这种动物对新异性所显示的效应,在心理学上就被叫做柯立芝效应。

对同一件事我们会很快就习惯了,并逐渐变得麻木。我把它提炼成一个思维模型,叫做习惯麻木。同时,我们又在不断的追求新鲜感,追求新的刺激。我把它提炼成一个思维模型,叫做追求新鲜。

对于同一件事情,我们每重复一次,阈值就会提高一点,需要更高的刺激才能达到跟原来一样的感觉。

2 成瘾机制

对于人类和其他哺乳类动物来讲,欲望和动机都来自一种叫做多巴胺的神经化合物。多巴胺让人脑中的奖赏机制活跃起来,让人类产生快感,它也是人们上瘾的原因,所以被称为成瘾分子。

但是多巴胺并不是一个坏东西,多巴胺可以促使你做一切有利于你的基因延续的事情,

新的事物可以刺激多巴胺,这也是为什么网络上的一些内容会刺激奖赏机制。因为鼠标一点,新的画面就出现了,随着多个同时打开的页面和无数的浏览,当一个大脑面对着它从未进化到可以处理超量 ...

编译原理第7章:语法制导翻译

第7章 语法制导翻译1 语法制导翻译概述

如何表示语义信息:为CFG中的文法符号设置语义属性,用来表示语法成分对应的语义信息。

如何计算语义属性:

文法符号的语义属性值是用与文法符号所在产生式(语法规则)相关联的语义规则来计算的

对于给定的输入串$x$ ,构建$x$的语法分析树,并利用与产生式(语法规则)相关联的语义规则来计算分析树中各结点对应的语义属性值

1.1 语法制导定义(SDD)SDD是对CFG的推广,将每个文法符号和一个语义属性集合相关联,将每个产生式和一组语义规则相关联,这些规则用于计算该产生式中各文法符号的属性值。

如果$X$是一个文法符号,$a$是$X$的一个属性,则用$X.a$表示属性$a$在某个标号为$X$的分析树结点上的值。

1.2 语法制导翻译方案(SDT)SDT是在产生式右部嵌入了程序片段的CFG,这些程序片段称为语义动作。按照惯例,语义动作放在花括号内。

一个语义动作在产生式中的位置决定了这个动作的执行时间。

1.3 SDD与SDTSDD是关于语言翻译的高层次规格说明,隐蔽了许多具体实现细节,使用户不必显式地说明翻译发生的顺序。

SDT可以看作是对S ...

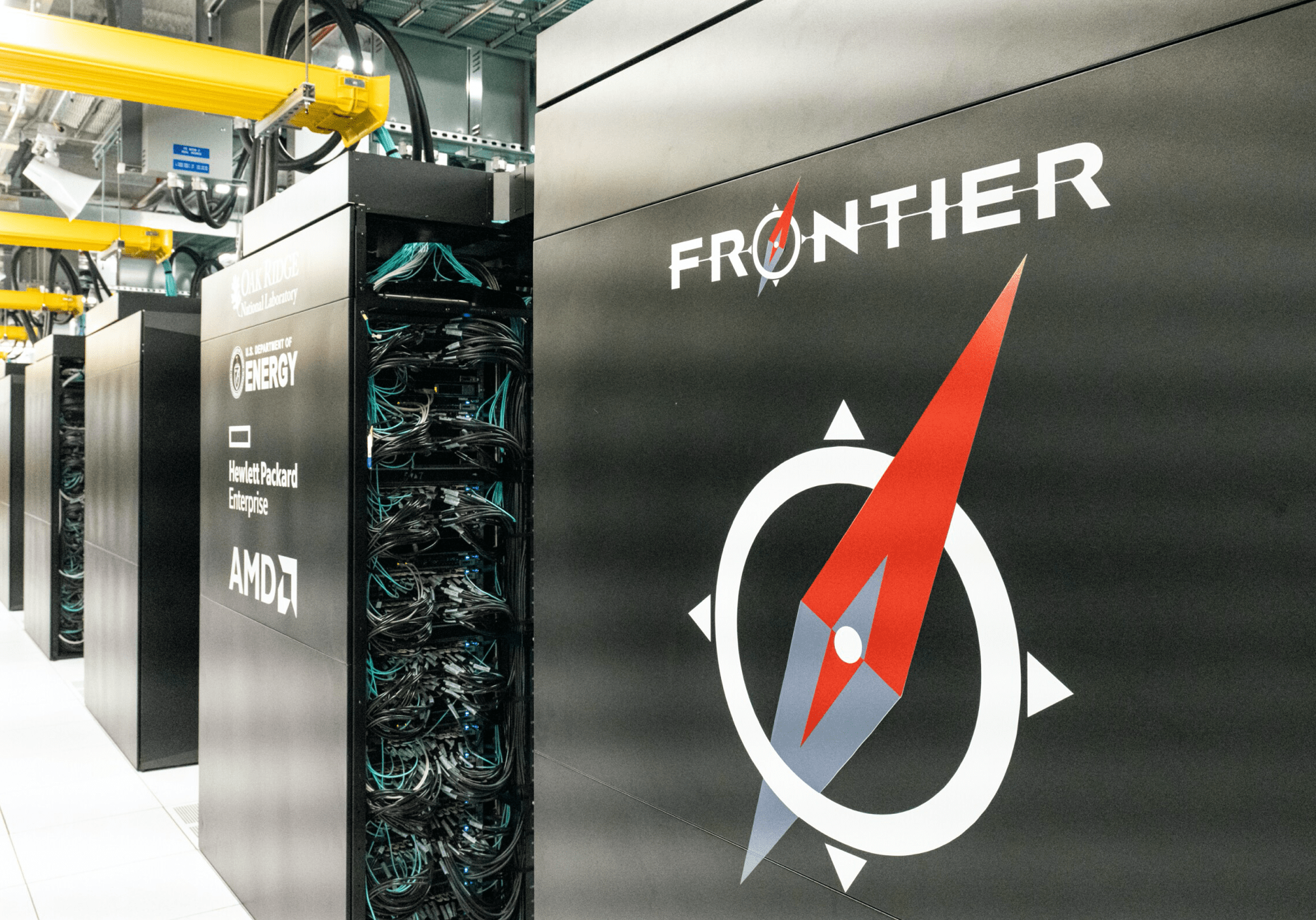

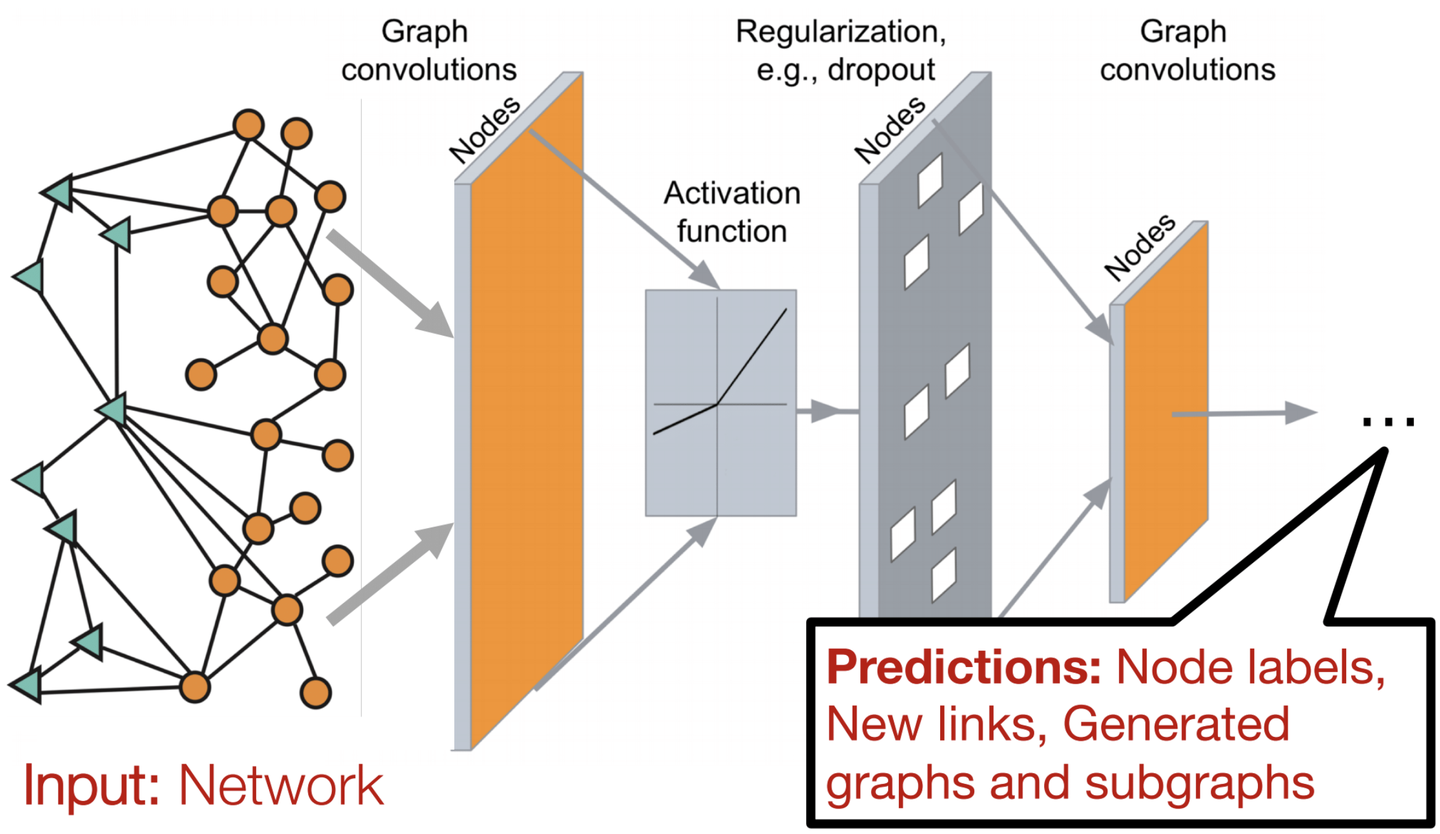

论文精读3:GNN技术博客

论文题目:A Gentle Introduction to Graph Neural Networks作者:Google发表时间:2021年

1 引言神经网络已适应利用图的结构和属性。我们探索构建图神经网络所需的组件——并激发它们背后的设计选择。

图就在我们身边;现实世界的对象通常是根据它们与其他事物的联系来定义的。一组对象以及它们之间的联系自然地表达为图形。十多年来,研究人员开发了对图数据进行操作的神经网络(称为图神经网络,或 GNN)。最近的发展提高了他们的能力和表达能力。我们开始看到抗菌药物发现等领域的实际应用,例如physics simulations(物理模拟)、fake news detection(假新闻检测)、traffic prediction(交通预测)和recommendation systems(推荐系统)。

本文探讨并解释了现代图神经网络。我们将这项工作分为四个部分。首先,我们看看哪种数据最自然地表达为图,以及一些常见的示例。其次,我们探讨图与其他类型数据的不同之处,以及使用图时必须做出的一些专门选择。第三,我们构建了一个现代 GNN,从该领域历史性的建 ...

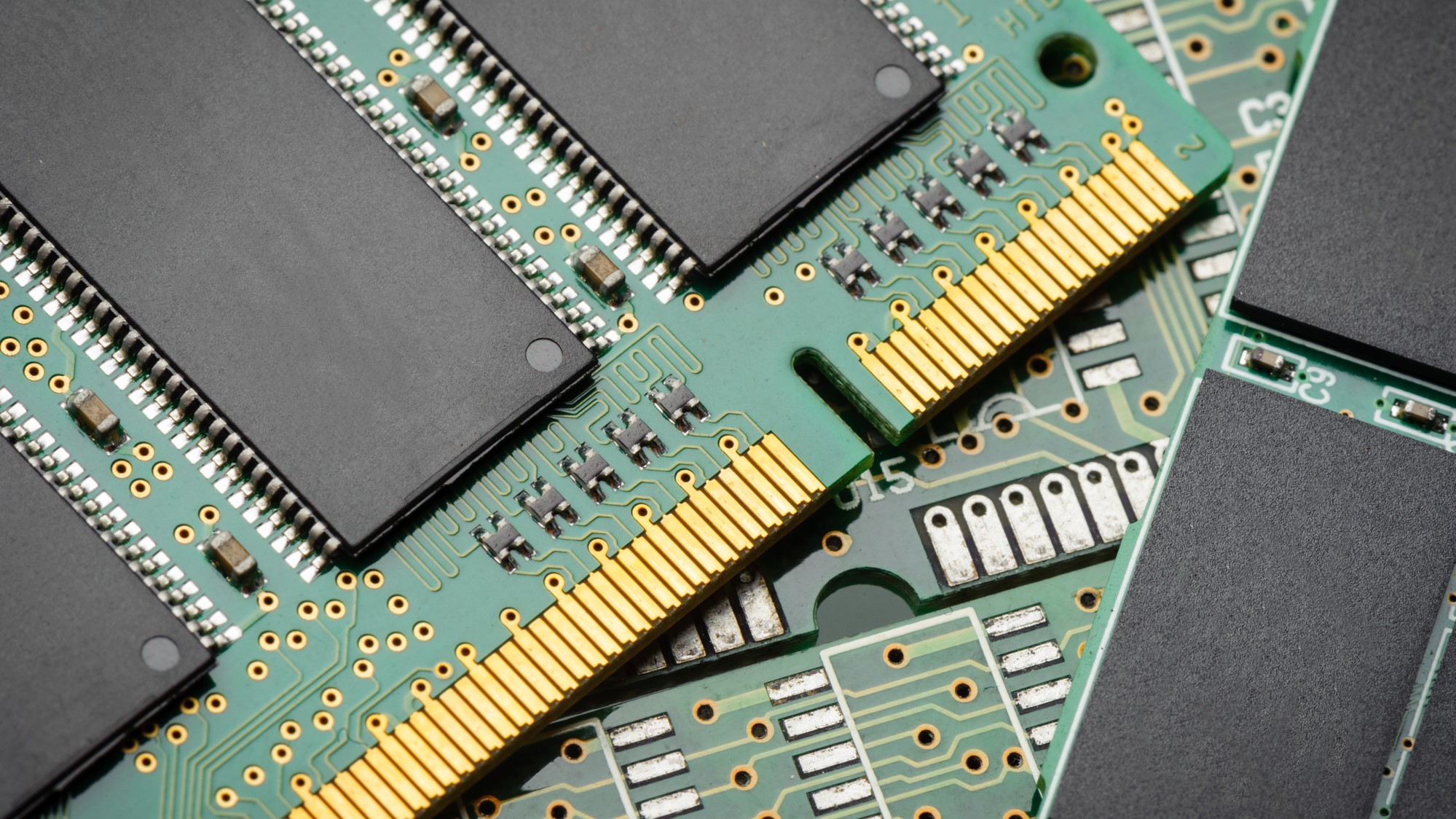

计算机组成原理第4章:存储器

1 存储器概述存储器是计算机系统中的记忆设备,用来存放程序和数据,计算机系统的运行速度在很大程度上受存储器制约。I/O与存储器直接数据交换大大提高系统性能。

1.1 存储器的分类1.1.1 按存储介质分类

1.1.2 按存取方式分类分为随机存储器、只读存储器、顺序存取存储器和直接存取存储器。

1.1.3 按在计算机中的作用分类

1.2 存储器的层次结构存储器有3个主要性能指标:速度、容量和位价。

存储器三个主要特性的关系:

存储系统层次结构主要体现在缓存—主存和主存—辅存2个存储层次上。

缓存—主存层次主要解决CPU与主存速度不匹配的问题,主存—辅存层次主要解决存储系统的容量问题。辅存的速度比主存的速度低,而且不能和CPU直接交换信息,但是容量比主存大得多,可以存放大量暂时未用到的信息,当CPU需要用到这些信息时,再将辅存的内容调入主存,供CPU直接访问。

在主存—辅存这一层次的不断发展中,逐渐形成了虚拟存储系统。

2 主存储器2.1 概述主存储器的基本组成如下:

主存和CPU之间的联系:

2.1.1 主存的技术指标2.1.1.1 存储容量存储容量:主存存放二进制 ...